本月早些时候,Alexandria Ocasio-Cortez提出算法,因为它们是由人类设计的,可以使人类的偏见永久化。虽然有些人仍然反对这个想法,但它已经被该领域的专家广泛接受了一段时间。正如科学记者玛吉·科尔斯-贝克(Maggie Koerth-Baker)所指出的那样,ProPublica存在一种整体性的机器偏见。我在2017年11月/ 12月的Muse杂志上写了一篇关于算法偏见和计算机科学家正在努力克服它的一些方法的文章,该杂志的读者是9-14岁左右的儿童。在这个版本中,我添加了一些链接以获得更多信息。

比如说你想申请一份新工作。你可以先写一份简历。这是一份列有你的姓名、学历和资格的文件。

但是研究表明,如果简历顶部的名字是Jennifer而不是John,或者是Lakisha而不是Laurie,人们对同一份简历的评价会有所不同。不管我们是否愿意,人类都有偏见。这些好恶让我们很难准确、公正地看待我们的世界。在很多工作中,人们更愿意雇佣约翰而不是詹妮弗或劳里,而不是拉基莎。这些人不会把自己描述成性别歧视者或种族主义者,但他们会无意识地偏爱某些群体。

偏见对每个人都是有害的。如果人们在做雇佣决定时允许他们的偏见影响他们,他们显然会伤害他们歧视的人。但他们也伤害了自己。他们的公司会因为人的偏见而失去优秀的员工。员工更多样化的公司往往比员工非常相似的公司表现更好。

那么,为什么不让电脑雇佣员工呢?一堆金属,或者组成程序的0和1,不可能是种族主义或性别歧视,对吧?问题解决了!

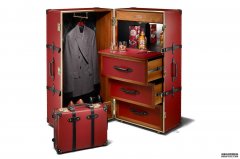

写的食谱

没有那么快。计算机没有自由意志和感情,但越来越多的计算机科学家、数据科学家和其他研究人员正在提请注意这样一个事实,即即使没有程序员插入任何明显的种族主义或性别歧视规则,算法也会加剧社会中的偏见。“很多人认为,因为算法是数学的,所以它们是自动公平的,”数据科学家凯西·奥尼尔(Cathy O’neil)说。“那不是真的。”

算法有点像菜谱。它是告诉计算机如何回答问题或做出决定的一组指令。(遗憾的是,这样做的结果不会像食谱的最终结果那样美味。)人工智能是一种特殊的计算机算法。“任何试图让计算机表现得像人类的东西”都是人工智能,Suresh Venkatasubramanian说。他是犹他大学的计算机科学家。计算机科学家、软件工程师和程序员从事不同方面的计算工作。这些方面包括人工智能、机器学习和算法。计算机科学家通常专注于该领域的理论方面,而软件工程师则设计计算机运行的程序。程序员从事创建算法的实际工作。如果算法就是食谱,那么程序员就是把它们写下来的烹饪书的作者。

一种流行的人工智能技术叫做机器学习。Venkatasubramanian说:“这是一种制造算法的算法。”机器学习算法着眼于过去如何做出决策的数据,并利用这些数据来做出未来的决策。

例如,当你去亚马逊或YouTube浏览下一本你想读的书或你想看的视频时,你会看到一个推荐列表。这些推荐是一种机器学习算法的结果,该算法研究了数百万次(如果不是数十亿次的话)点击量,并找出与你有相同偏好的人倾向于选择什么书或视频。

这为潜在的问题埋下了伏笔。“它模仿过去发生的一切,”数据科学家凯西·奥尼尔说。“在我们拥有一个完美的社会之前,我们可能需要对此保持谨慎。”对于亚马逊或YouTube的推荐,这些偏见似乎相当无害。你可能会收到一些不吸引你的推荐书目,或者错过你喜欢的视频。但有偏见的算法也会产生更明显的负面影响。

20世纪80年代初,英国伦敦的一所医学院开始使用一种算法进行第一轮招生筛选。他们根据前十年的数据对算法进行了训练。在那期间,做出录取决定的人歧视妇女和非欧洲人。该算法的目的是模仿人类的选择,它更喜欢男性而不是女性,也更喜欢名字听起来像欧洲人的人而不是欧洲人。“现在发生了很多微妙的事情,但它们仍然在发生,”奥尼尔说。

作为一个更现代的例子,一些面部识别程序在识别深色皮肤的人的脸方面比浅色皮肤的人差。在这种情况下,问题首先在于使用了什么数据。可能没有意识到,程序员们使用的算法大多是浅肤色的人的脸。当研究对象的肤色范围更广时,这些算法就会出错。在一个案例中,一个图像识别程序将两个人的照片标记为“大猩猩”。这是一种冒犯性的种族侮辱。但计算机程序并不知道这一点。尴尬的工程师很快修正了这个错误。即使程序员或算法本身没有任何恶意,人们也会被有偏见的算法伤害。

编写算法的程序员有几种方法可以克服偏见。在人脸识别算法方面,程序员本可以使用更广泛的人脸来训练算法。算法设计者可以尝试确保他们的数据真正代表它所涉及的总体。如果你要用它来分类人们的照片,如果它只对浅肤色的人有效那就不好了。

医学院可能需要一个不同的解决方案。问题不在于算法的数据太少,而在于它反映出的数据存在历史偏差。一种选择是告诉算法忽略性别或姓氏,但即使这样也不能解决问题。该算法可以识别出与性别或国籍有关的因素。例如,它可能会开始歧视那些上过女生比男生多的学校的人,或者那些住在有大量移民的社区的人。

对公平

Venkatasubramanian还有一个稍微令人吃惊的建议:让算法更加随机。“如果你总是随机的,你可能会做出糟糕的决定,”他说。“但你应该时不时地做一些非常随机的事情。”他和他的同事最近做了一项研究,表明包含少量随机性的机器学习算法比试图严格模拟训练数据的算法更公平。在某种意义上,他说,“你想让算法认识到它不可能是确定的。”(要阅读Venkatasubramanian和他的合著者撰写的一篇关于可以克服算法偏差的技术的论文,请点击这里。)

Venkatasubramanian说,我们得到的结论是,我们不应该对算法过于自信。我们需要意识到潜在的偏见和对我们使用的算法的公平性的怀疑。算法并不都是坏的。我们能够超越人类主体性的想法是一件好事。但是,他补充说,“把我们所有的信心都放在机器上是行不通的。”如果有适当的怀疑,我们也许能做得更好。“与其强化社会现有的偏见,还不如结合他和其他人的建议的算法,实际上可以帮助我们更公平地做出决定。”就像我们一开始想的那样。

相关阅读:杏耀注册,丑陋的水果和蔬菜能拯救世界吗

相关阅读:杏耀注册,如何变得更独立